揭示ChatGPT全稱及其背后含義解析

發(fā)布日期:2024-10-15 瀏覽次數(shù):1513

ChatGPT,全稱為Chat Generative Pre-trained Transformer,是一種基于深度學(xué)習(xí)的自然語言處理技術(shù)。該技術(shù)由美國Open

AI公司于2022年11月推出,引起了全球關(guān)注。本文將揭示

ChatGPT的全稱及其背后含義,并對(duì)其進(jìn)行解析。

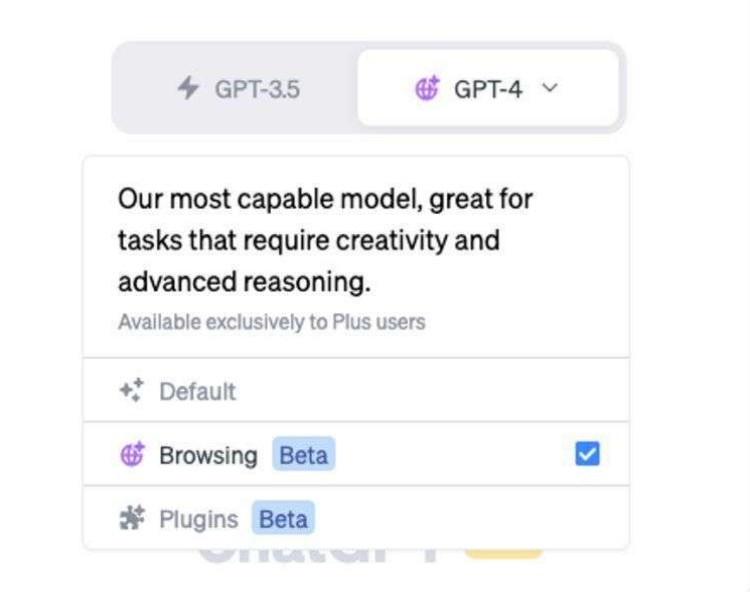

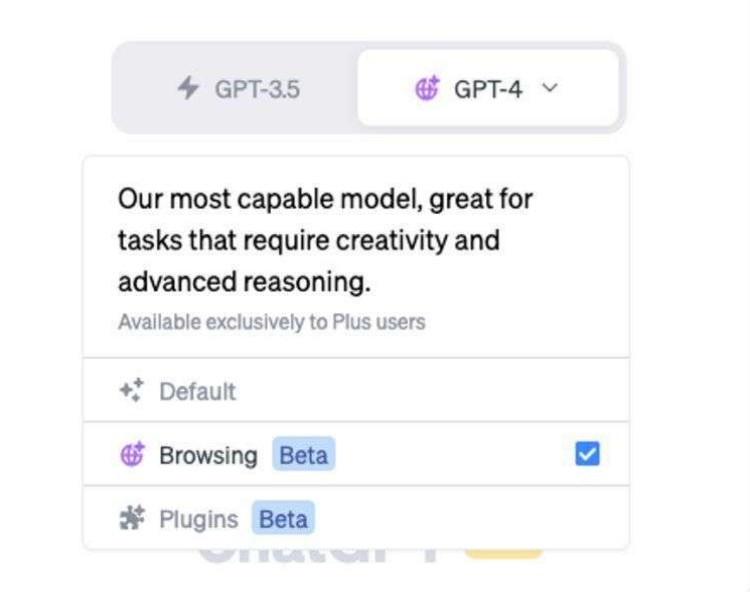

首先,我們來解析

ChatGPT的全稱。Chat表示該技術(shù)主要用于聊天場(chǎng)景,Generative表示其具有生成性,Pre-trained表示模型在訓(xùn)練之前已經(jīng)進(jìn)行了預(yù)訓(xùn)練,Transformer則是指其采用的模型結(jié)構(gòu)。

1. Chat:聊天場(chǎng)景

ChatGPT的設(shè)計(jì)初衷是為了應(yīng)用于聊天場(chǎng)景,它可以與人類進(jìn)行自然、流暢的對(duì)話。與傳統(tǒng)的聊天機(jī)器人相比,ChatGPT具有更高的智能化水平,能夠根據(jù)上下文理解用戶的意圖,并給出恰當(dāng)?shù)幕卮稹_@使得ChatGPT在聊天、問答、咨詢等場(chǎng)景中具有廣泛的應(yīng)用前景。

2. Generative:生成性

Generative表示ChatGPT具有生成性,即它能夠根據(jù)輸入的上下文生成新的文本。這種生成性來源于模型在訓(xùn)練過程中學(xué)習(xí)到的語言規(guī)律和知識(shí)。通過對(duì)大量文本數(shù)據(jù)進(jìn)行訓(xùn)練,ChatGPT能夠捕捉到語言的深層結(jié)構(gòu),從而生成符合語法規(guī)則和語義邏輯的文本。這使得ChatGPT在文本生成、摘要、翻譯等任務(wù)中表現(xiàn)出色。

3. Pre-trained:預(yù)訓(xùn)練

Pre-trained表示ChatGPT在訓(xùn)練之前已經(jīng)進(jìn)行了預(yù)訓(xùn)練。預(yù)訓(xùn)練是一種在大量無標(biāo)注數(shù)據(jù)上訓(xùn)練模型的方法,旨在讓模型學(xué)習(xí)到語言的通用表示。通過對(duì)大規(guī)模文本數(shù)據(jù)進(jìn)行預(yù)訓(xùn)練,ChatGPT能夠獲取到豐富的語言知識(shí)和語義信息,從而在下游任務(wù)中取得更好的表現(xiàn)。

4. Transformer:模型結(jié)構(gòu)

Transformer是ChatGPT采用的模型結(jié)構(gòu)。Transformer是一種基于自注意力機(jī)制的深度神經(jīng)網(wǎng)絡(luò)模型,具有強(qiáng)大的并行計(jì)算能力和良好的性能。在自然語言處理任務(wù)中,Transformer模型能夠有效地捕捉到長(zhǎng)距離依賴關(guān)系,提高模型的預(yù)測(cè)準(zhǔn)確性。

接下來,我們對(duì)ChatGPT背后的技術(shù)進(jìn)行解析。

1. 自注意力機(jī)制

自注意力機(jī)制是Transformer模型的核心組成部分。它允許模型在處理輸入序列時(shí),自動(dòng)關(guān)注到重要的部分。通過自注意力機(jī)制,ChatGPT能夠捕捉到輸入文本中的關(guān)鍵信息,提高對(duì)話生成的質(zhì)量。

2. 上下文感知

ChatGPT具有上下文感知能力,能夠根據(jù)輸入的上下文理解用戶的意圖。這得益于模型在訓(xùn)練過程中學(xué)習(xí)到的語言規(guī)律和知識(shí)。通過對(duì)上下文的理解,ChatGPT能夠生成更加準(zhǔn)確、自然的回答。

3. 多任務(wù)學(xué)習(xí)

ChatGPT采用了多任務(wù)學(xué)習(xí)策略,即在同一模型中同時(shí)訓(xùn)練多個(gè)任務(wù)。這種方法可以讓模型在不同任務(wù)中共享知識(shí),提高模型的泛化能力。在聊天場(chǎng)景中,ChatGPT可以同時(shí)完成文本生成、問答、推理等任務(wù),表現(xiàn)出色。

4. 無監(jiān)督學(xué)習(xí)

ChatGPT的訓(xùn)練過程采用了無監(jiān)督學(xué)習(xí)策略。無監(jiān)督學(xué)習(xí)讓模型在大量無標(biāo)注數(shù)據(jù)中自動(dòng)發(fā)現(xiàn)規(guī)律,避免了人工標(biāo)注數(shù)據(jù)的成本和誤差。這種訓(xùn)練方式使得ChatGPT具有更好的泛化能力和魯棒性。

總之,ChatGPT作為一種基于深度學(xué)習(xí)的自然語言處理技術(shù),具有強(qiáng)大的聊天能力、生成性和預(yù)訓(xùn)練優(yōu)勢(shì)。它的成功應(yīng)用為

人工智能領(lǐng)域帶來了新的突破,也為人們的生活帶來了更多便利。隨著技術(shù)的不斷發(fā)展,ChatGPT有望在更多場(chǎng)景中發(fā)揮重要作用。